Webseiten mit Sitzungs-IDs, Sortierfunktionen oder anderen Parametern in der URL werden oft nicht optimal von Google gecrawlt und indexiert. Oft sind identische Inhalte unter verschiedenen URLs zu finden, ein klassisches Duplicate Content Problem. Zudem indexiert der Googlebot möglicherweise eine große Anzahl identischer Seiten und lässt andere, wichtigere Seiten unberücksichtigt. Durch den canonical-Tag kann Google die bevorzugte Seite mitgeteilt werden. In den Webmastertools gibt es seit einigen Wochen eine weitere Funktion, mit der Google die Bedeutung der verschiedenen Parameter mitgeteilt werden kann.

Findet der Googlebot verschiedene URLs mit identischen Inhalten, werden diese Seiten im Allgemeinen geclustert. Die am besten passende URL des Clusters wird automatisch für die Suchmaschine ausgewählt. Mit der neuen Funktion in den Webmastertools haben Webseitenbetreiber, die mit den Parametern auf ihrer Seite vertraut sind, nun die Möglichkeit, in diesen Prozess einzugreifen und konkret anzugeben, ob der Parameter auf den Seiteninhalt einen Einfluss hat und wie URLs mit diesen Parametern zu crawlen sind.

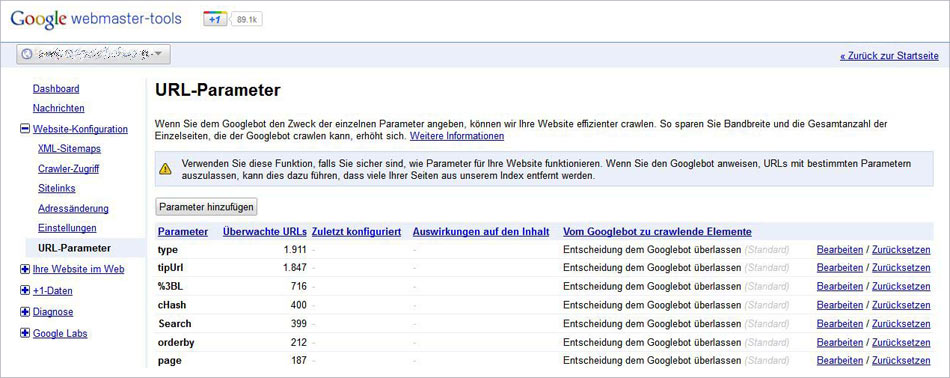

Die neue Funktion findet sich unter dem Punkt Website-Konfiguration und nennt sich „URL-Parameter“. Hier werden alle gefundenen Parameter aufgelistet. In der Standard-Einstellung wird die Entscheidung darüber, wie mit dem jeweiligen Parameter zu verfahren ist, dem Googlebot überlassen. Jeder einzelne Parameter kann jedoch bearbeitet werden. Außerdem können neuen Parameter hinzugefügt werden.

Bei der Bearbeitung der Parameter ist auf jeden Fall Vorsicht geboten. Unbedingte Voraussetzung für die Nutzung der Funktion ist die genaue Kenntnis über die einzelnen Parameter auf der eigenen Seite. Falsch angewendet, können unter Umständen wichtige Bereiche der Webseite von der Indexierung ausgeschlossen werden.

Grundsätzlich wird zwischen zwei Möglichkeiten unterschieden: verändert ein Parameter den Inhalt einer Seite, indem Inhalte sortiert, übersetzt, eingeschränkt oder anderweitig angepasst werden, oder hat er keinen Einfluss auf den Content? Hat er keinen Einfluss (zum Beispiel, weil es sich um eine Session-ID handelt), sind keine weiteren Einstellungen notwendig. Der Googlebot wird von einer Gruppe an URLs, die sich nur durch diesen einen Parameter unterscheiden, nur stellvertretend eine dieser URLs crawlen. Ändert sich der Inhalt einer Seite (zum Beispiel durch Parameter wie sort, page oder lang für Sortierung, Seitenzahl oder Sprache), kann dem Googlebot mitgeteilt werden, wie mit den URLs verfahren werden soll. Auch hier wird per default dem Googlebot die Entscheidung überlassen. Alternativ kann ausgewählt werden, dass jede URL, nur URLs mit einem bestimmten Wert oder gar keine URLs mit diesem Parameter gecrawlt werden sollen. Im letzteren Fall ist der Ausschluss per robots.txt jedoch vorzuziehen.) Praktischerweise lassen sich alle Parameter mit ihren Einstellungen als Tabelle herunterladen, um sich detailliert mit ihnen auseinanderzusetzen.

Unabhängig von der Verwendung von rel = canonical ist das neue Feature eine gute Möglichkeit die Indexierung der Seite zu optimieren und den Googlebot optimal durch die eigene Domain zu navigieren.